LA RIVOLUZIONE QUANTISTICA DEL XX SECOLO

- LA NUOVA SCIENZA DEL XX Secolo

Nel 1890 lord Kelvin, massimo rappresentante del tempo della scienza britannica, poteva affermare, in una conferenza alla Royal Society di Londra, che la scienza aveva raggiunto tutti i suoi obiettivi e che nel prossimo secolo non ci potevano essere grandi scoperte, segnalava solo due inquietanti problemi non ancora risolti: lo strano esperimento di Michelson per il quale sembrava che la velocità della luce non risentiva del moto della terra e l’emissione del corpo nero che sembrava dover emettere un’energia infinita. Queste due “nuvolette” all’orizzonte della scienza saranno nei primi decenni del nuovo secolo alla base della Relatività, la prima, e della Teoria Quantistica, la seconda, due teorie che hanno cambiato completamente il nostro modo di vedere il tempo, lo spazio ed il mondo microscopico della materia.

La Relatività è stata praticamente opera del genio di Einstein ed ha avuto anche una grande popolarità per merito di una vasta opera di divulgazione dei media ed anche da parte di scienziati di valore fra cui lo stesso Einstein. La Relatività ha avuto effetti rivoluzionari in cosmologia ma ha lasciato invariata la meccanica classica per velocità non paragonabili a quelle della luce e valori di gravità modesti e nelle applicazioni pratiche si configura come una migliore approssimazione delle leggi di Newton. Lo stesso non si può dire della Teoria dei Quanti o Meccanica Quantistica che ha avuto un impatto inferiore sul grande pubblico per una divulgazione più superficiale ma i suoi effetti sono stati molto più rivoluzionari in fisica nel campo delle particelle elementari e nell’interpretazione dei fenomeni. Tutti gli sviluppi della fisica atomica e della tecnologia elettronica sarebbero stati impossibili senza le basi teoriche ed il formalismo della teoria dei quanti. La Meccanica Quantistica in più ha prodotto una rottura definitiva con i principi della fisica classica e le sue conseguenze si sono rivelate in contrasto con la comune intuizione. Questa frattura ha provocato contrapposizioni e vivaci discussioni fra i fisici nella prima metà del XX secolo e solo negli anni ’80 si è arrivati all’accettazione anche dei principi più contestati.

- LE BASI DELLA TEORIA

- LA COSTANTE DI PLANCK

Secondo la meccanica classica la radiazione di corpo nero avrebbe dovuto portare alla cosiddetta catastrofe ultravioletta, cioè ad un’emissione infinita alle frequenze più alte, questo perché il livello di energia della radiazione cresce in modo continuo con la frequenza ed all’interno della cavità che costituisce il modello del corpo nero sono possibili tutte le infinite frequenze superiori ad una minima. Nella realtà l’energia a disposizione nella cavità è finita ma i fisici non sapevano come distribuire l’energia fra le infinite frequenze possibili. Il fisico tedesco Max Planck nel 1900 propose, come unica soluzione che l’energia crescesse solo per multipli di un quanto di energia in modo discontinuo; questo quanto corrispondeva ad un’energia hf dove h era una costante (detta poi costante di Planck) e f era la frequenza di emissione. Questi quanti crescevano con la frequenza ma non potevano esistere valori intermedi e c’era un limite anche alla frequenza massima essendo l’energia totale finita. Essendo quindi limitato il numero delle frequenze era possibile distribuire l’energia fra di esse. Nasceva così l’idea del quanto di energia ma stentò ancora ad essere accettata perché dopo Maxwell l’energia elettromagnetica era un’onda e l’ipotesi corpuscolare di Newton era stata abbandonata.

- EINSTEIN E L’EFFETTO FOTOELETTRICO

Dopo che Planck ebbe introdotto l’ipotesi della quantizzazione dell’energia con la costante h, Einstein, nel 1905, osservando che l’effetto fotoelettrico avviene solo oltre una certa frequenza della radiazione incidente e che dalla frequenza dipende anche l’energia degli elettroni emessi, scrisse una delle sue famose memorie proponendo la teoria che la luce fosse costituita da quanti (particelle) e che l’emissione richiedesse un quanto di energia hf diverso per ogni metallo. Einstein, come per la relatività, anche in questo caso ebbe il coraggio di andare contro le idee consolidate del suo tempo e fu quindi uno dei padri della fisica quantistica. Nel 1921 ricevette il premio Nobel per la spiegazione dell’effetto fotoelettrico dopo che fin dal 1911 la giuria gli aveva rifiutato quello per la relatività ristretta che si riteneva ancora non sufficientemente provata. Per il suo lavoro Planck aveva ottenuto il Nobel nel 1918.

Il 1905 fu un anno straordinario (annus mirabilis) per Albert Einstein, nato a Ulm in Germania nel 1879, perché all’età di 26 anni e mentre lavorava all’ufficio brevetti di Berna, pubblicò cinque memorie tre delle quali rivoluzionarie per la fisica. Oltre a quella sull’effetto fotoelettrico la sua prima memoria fu sull’elettrodinamica dei corpi in movimento con cui introdusse la relatività ristretta per i sistemi che si muovono a velocità costante, teoria che nel 1916 estenderà, con la relatività generale, anche ai sistemi che si muovono di moto accelerato. Con un altro lavoro nello stesso anno spiegò il moto browniano, un fenomeno scoperto nel XIX secolo da Robert Brown, un botanico scozzese che osservando al microscopio minuscoli semi di piante in sospensione nell’acqua li vide muoversi in modo caotico e pensò si trattasse di una forza vitale ma poi osservò lo stesso effetto in sottilissime particelle di gesso in sospensione. Einstein spiegò per primo che questo moto irregolare delle particelle, detto appunto browniano, era dovuto agli urti casuali delle

molecole del liquido in agitazione termica e ne fece un’analisi quantitativa. Fu la prima dimostrazione della costituzione discreta della materia.

- IL MODELLO DELL’ATOMO DI BOHR

Il fisico danese Niels Bohr, sulla scia di Planck ed Einstein, applicò i vincoli quantistici alle particelle elementari utilizzando la costante di Planck e, nel modello atomico di Rutherford, impose alle orbite degli elettroni la condizione che il loro momento angolare mvr (m è la massa, v è velocità, r il raggio dell’orbita) fosse uguale a un multiplo di h’, la costante di Planck divisa per 2 pigreco. Suppose inoltre che quando un elettrone saltava da un livello ad un altro contiguo assorbiva o emetteva un fotone con energia hf. La descrizione del modello dell’atomo, pubblicata nel 1913, non era più nei termini della fisica classica, che aveva dimostrato di non funzionare, ma nella nuova teoria quantistica che così permetteva di spiegare le righe di emissione discrete degli atomi.

- LA SCUOLA DI COPENHAGEN

La teoria quantistica venne elaborata, oltre che da Bohr, da Werner Heisenberg, Max Born e Wolfgang Pauli che insieme fondarono la scuola di Copenhagen, rimasta a lungo depositaria dell’interpretazione ortodossa della teoria, e nel 1922 Bohr vinse il Nobel per la fisica per il suo lavoro. L’idea di Bohr sulla sperimentazione scientifica è che usando dispositivi macroscopici per misurare comportamenti del mondo microscopico i risultati sono descrivibili nel linguaggio della fisica classica ma la descrizione del mondo quantistico rimane astratta. Il positivismo è l’unico atteggiamento corretto perché basato sull’osservazione e la verifica diretta dei fenomeni. Se misure diverse mettono in luce aspetti diversi che si contraddicono invece di completarsi non devono meravigliare perché non sono confrontabili non potendo essere eseguite contemporaneamente. Bohr introduce la nozione di complementarietà fra i diversi comportamenti dei fenomeni del mondo microscopico, come onda e corpuscolo, ma è una nozione che non contribuisce alla comprensione. La posizione di Heisenberg (nato in Baviera nel 1901) è ancora più rigidamente positivista; l’unica realtà sta nel processo di osservazione e nei suoi risultati, le particelle elementari non hanno lo stesso grado di realtà ma hanno solo delle potenzialità ed il loro stato è indeterminato fino all’atto della misura. Heisenberg e Pauli rifiutano, in opposizione a Bohr, qualsiasi tentativo di schematizzazione e visualizzazione di modelli atomici perché producono solo contraddizioni. Heisenberg sviluppò la teoria della meccanica quantistica in modo astratto con il metodo delle matrici. Poiché il prodotto di due matrici, |A| e |B|, non gode della proprietà commutativa, cioè il prodotto |A||B| è diverso da |B||A|, si ha come conseguenza che se di una particella si misurano posizione x e quantità di moto p (massa per velocità) i risultati sono diversi secondo l’ordine della misura e se la prima misura viene eseguita con buona precisione la seconda risulterà di precisione molto scarsa; questo è il principio di indeterminazione di Heisenberg espresso come dx*dp >/= h (costante di Planck) e significa che la prima misura modifica in modo irreversibile la seconda grandezza osservata. Se si misura prima x con una piccola dispersione, la misura di p eseguita successivamente avrà una dispersione almeno inversamente proporzionale a quella di x. A Pauli (nato a Vienna nel 1900) si deve il principio di esclusione che prese il suo nome per il quale due elettroni non possono avere lo stesso stato quantico perché sarebbero indistinguibili e più tardi il principio fu esteso a tutte le particelle con spin semi- intero (fermioni). Per questo principio Pauli ottenne il Nobel nel 1945.

- L’EQUAZIONE D’ONDA DI SCHRÖDINGER

Erwin Schrödinger, austriaco di Vienna, ancora fedele ai criteri di visualizzazione dei fenomeni, cercò un modello teorico per la meccanica quantistica ispirandosi alle idee di De Broglie sulla natura ondulatoria dei processi fisici e trovò un’equazione che descrive il comportamento delle onde associate alle particelle quantistiche, si tratta di un’espressione differenziale del primo ordine rispetto al tempo ma del secondo ordine rispetto alla posizione. Le soluzioni di questa equazione sono onde e da esse derivarono le proprietà di probabilità e di sovrapposizione degli stati delle particelle quantistiche. Secondo un’interpretazione non ambigua, proposta poi da Born ed inserita nella teoria ortodossa, questa probabilità non è quella che ha una particella di trovarsi in una data posizione, ma quella che “venga trovata” in quella posizione quando si esegue la misura ed è pari al modulo quadrato della funzione d’onda calcolata in quel punto. Lo stato di una particella quantistica prima della misura è dato dall’insieme delle soluzioni dell’equazione, il pacchetto d’onde, o meglio dalla sovrapposizione di più soluzioni mutuamente esclusive ciascuna con la sua densità di

probabilità. La misurazione conferisce realtà fisica ad un fenomeno e come tale è un processo non lineare e irreversibile, prima non si può attribuire nessuno stato determinato alle grandezze quantistiche ed esperimenti diversi portano a risultati diversi. La funzione d’onda, in presenza del sistema di misura macroscopico con cui interagisce, si riduce (collassa) in uno dei valori previsti eliminando ogni sovrapposizione di stati quantistica. Schrödinger accettò l’indeterminismo quantistico al contrario di Einstein ma ebbe difficoltà ad accettare questo salto quantico che si verifica all’atto della misura; nel 1926 dimostrò infine l’equivalenza tra la meccanica ondulatoria dell’equazione delle onde e la meccanica delle matrici di Heisenberg.

Heisenberg ottenne il premio Nobel nel 1932, Schrödinger nel 1933 e Born solo nel 1954.

- UN PASSO INDIETRO: IL DUALISMO ONDA-CORPUSCOLO.

- L’ESPERIMENTO DI THOMAS YOUNG

Nel 1801 il fisico inglese Thomas Young (1773-1829), proiettando una luce monocromatica su una piastra con due fenditure e raccogliendo le uscite su un secondo schermo, osservò delle figure di interferenza. Una figura di interferenza è il marchio caratteristico delle onde e veniva a cadere l’ipotesi corpuscolare della luce avanzata da Newton. Con la teoria elettromagnetica di Maxwell cadde poi ogni dubbio. La luce è quindi un’onda ed il fisico francese Louis de Broglie nel 1923 mise in relazione la quantità di moto p di una particella elementare con la costante di Planck mediante la relazione p = hf/c dove c/f è la lunghezza d’onda dell’onda associata alla particella che chiamò “onda pilota”; egli estese il dualismo onda-corpuscolo anche alle particelle elementari come gli elettroni e gli esperimenti gli diedero ragione, per questo de Broglie ebbe il Nobel nel 1929. Su questa base nel 1933 è stato costruito il primo microscopio elettronico la cui maggiore discriminazione sfrutta la più corta lunghezza d’onda associata agli elettroni con quantità di moto p. Durante il 1900 l’esperimento di Young delle due fenditure fu ripetuto usando luce formata da singoli fotoni e si vide che ciascuno cadeva singolarmente sul secondo schermo ma, facendo passare un numero sufficiente di fotoni, sullo schermo compariva gradualmente la stessa figura di interferenza; sembrava che il singolo fotone interferisse con se stesso. Figure di interferenza si ottennero con elettroni e neutroni e recentemente anche con molecole complesse (fullereni) come una sfera composta da 70 atomi di carbonio. Fotoni ed elettroni si comportano come se attraversassero contemporaneamente le due fenditure. La descrizione quantistica è quella della funzione d’onda applicata al sistema composto dalle due fenditure che fornisce la probabilità del fotone o della particella di cadere in un punto dello schermo. La funzione d’onda dipende quindi anche dal sistema di misura e non ha senso parlare di ciò che succede prima che il fotone raggiunga lo schermo; solo in modo astratto si può dire che al passaggio delle due fenditure il fotone si trova in modo indeterminato su ambedue. Il fisico Richard Feynman dirà poi che questo esperimento rappresenta il mistero fondamentale della meccanica quantistica.

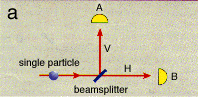

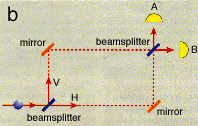

Il fisico americano John Archibald Wheeler descrisse anche una variante dell’esperimento delle due fenditure di Young dividendo un raggio di luce in due raggi, uno trasmesso ed uno riflesso, mediante uno specchio semi-argentato detto per questo divisore di fascio (beamsplitter). Nella Figura a è illustrata la semplice configurazione di uno specchio semi-argentato e dei due fasci che raggiungono due rivelatori. Si deve notare che il fascio riflesso V, per ragioni di continuità del campo sulla superficie riflettente, è sfasato di 90° rispetto al fascio trasmesso H. Se ora si fa incidere un fotone per volta esso sarà rivelato in modo completamente casuale da uno o dall’altro dei due rivelatori con una probabilità del 50%. Nella configurazione di Figura b (detta “Interferometro di Mach-Zehnder”) lo schema è completato da due specchi a 45° che riflettono i fasci in modo da farli incrociare dopo aver descritto un rettangolo e nel punto di incrocio è disposto un altro specchio semi-argentato, i fasci infine finiscono su due rivelatori. Solo il rivelatore B indicherà l’arrivo del fotone mentre su A la risposta è sempre nulla indicando interferenza negativa come se il fotone fosse passato per ambedue i percorsi combinandosi poi in fase in B ed in opposizione di fase in A, tenendo conto degli sfasamenti nella riflessione sugli specchi. In assenza del secondo divisore di fascio il fotone sceglie una sola strada ed i due rivelatori hanno uguale probabilità di registrare un’uscita; inserendolo, è come se passasse per ambedue e questo succede anche se il secondo specchio semi-argentato viene disposto con ritardo (scelta ritardata) dopo che il fotone ha attraversato il primo. Lo sperimentatore può così decidere ciò che deve essere successo nel passato e Wheeler definì questo “una legge senza legge” (law without a law); da qui l’affermazione di Wheeler che in un sistema quantistico “un fenomeno non è un fenomeno se non è un fenomeno misurato”, misure diverse non possono essere contemporanee e quindi possono dare risultati diversi.

- L’EFFETTO COMPTON

Un altro fenomeno in cui è evidente la doppia natura dei fotoni è l’effetto Compton scoperto nel 1922 dal fisico americano Arthur Compton che per questo ebbe il premio Nobel nel 1927. Egli osservò come rimbalzavano i raggi X sul reticolo di certi cristalli. Al variare dell’angolo di riflessione cambiava la loro energia e conseguentemente la loro frequenza. Nell’interazione con gli elettroni del reticolo c’era anche una cessione di energia secondo multipli della costante di Planck. Il comportamento di elettroni e fotoni sembra quello di due palle di biliardo ma non lo è; l’angolo di riflessione non è deterministico ma è come quello della diffusione di un’onda da un ostacolo, solo che il singolo fotone ha probabilità diverse di essere riflesso in direzioni diverse ed anche qui una funzione d’onda descrive posizione e quantità di moto dell’elettrone e del fotone riflesso. Se usiamo un fotone molto energetico possiamo determinare con più precisione dove avviene l’impatto e quindi la posizione dell’elettrone nel reticolo ma l’indeterminazione della sua velocità dopo l’impatto sarà maggiore. Se si usa un fotone di bassa energia, sarà meno precisa la posizione dell’elettrone rispetto alla sua quantità di moto e, poiché le due misure non si possono fare contemporaneamente, si può ottenere con precisione solo una delle due informazioni e la probabilità è ineliminabile.

- COMPORTAMENTO QUANTISTICO DELLA LUCE POLARIZZATA

Se si fa passare un fascio di luce non coerente attraverso un filtro polarizzatore verticale quello che uscirà è una luce tutta polarizzata verticalmente che successivamente verrà bloccata se si dispone in cascata un filtro polarizzatore orizzontale. Se però il filtro che segue è inclinato ad esempio a 45° passerà solo una metà dell’energia (quella della componente verticale). Questo è apparentemente un comportamento classico ma, se si riduce l’intensità in modo da far passare un solo fotone per volta, il singolo fotone passa o non passa attraverso il polarizzatore a 45° e si può verificare che ha una probabilità di passare del 50%. Se poi la polarizzazione del filtro è disposta con inclinazioni diverse da 45°, la probabilità seguirà una legge dipendente dal coseno dell’angolo e precisamente sarà uguale al quadrato del coseno che corrisponde al modulo quadrato della funzione d’onda.

Formalizzando la funzione d’onda del fotone a polarizzato verticalmente che si vuole sottoporre a misure di polarizzazione su uno dei due assi, 45° e 135° fra loro perpendicolari, si scrive (secondo una simbologia dovuta a Dirac):

|P> = |a,V> = 2^-½*|a,45> + 2^-½*|a,135> 3.1)

dove il coefficiente 2^-½ (inverso di radice di 2), se elevato al quadrato (1/2), è la probabilità di superare la prova su ciascuno dei due assi. L’espressione 3.1) rappresenta la sovrapposizione di due stati del fotone a nei riguardi dei polarizzatori a 45° e 135°.

In generale se si decompone la polarizzazione verticale di una particella a secondo un diversa coppia di assi

X e Y, fra loro perpendicolari che formano un angolo u fra V e X, si può scrivere:

|a,V> = cos u *|a,X> + sen u *|a,Y > 3.2)

essendo cos²u e sen²u le due probabilità di superare la prova nei due assi e naturalmente:

cos²u + sen²u = 1

La quantizzazione trasforma le certezze della meccanica classica in probabilità ma in questo caso si tratta di una probabilità non dipendente dalla nostra ignoranza del meccanismo esatto, come nel caso del lancio di una moneta, ma intrinseca alla natura delle grandezze quantistiche. La previsione della probabilità si riferisce inoltre esclusivamente al risultato della misura e non rappresenta una realtà a monte. Anche in questo caso la funzione d’onda si applica al sistema di misura (polarizzatore) dove si ha la sovrapposizione di due stati: passa o non passa.

Un’altra grandezza quantistica, che però non ha equivalente in meccanica classica, è lo spin di un elettrone o di altre particelle che in una misura può dare un risultato su o giù e ciò che si dice per le polarizzazioni dei fotoni si può dire per lo spin.

IL DIBATTITO EINSTEIN – BOHR.

Alla fine del 1927 la formulazione della teoria quantistica era stata matematicamente precisata e la comunità scientifica aveva accettato la natura insieme ondulatoria e corpuscolare delle particelle elementari e la quantizzazione dei processi. Nel 1928 il fisico inglese Paul Dirac superò anche l’incompatibilità fra Meccanica Quantistica e Relatività Ristretta con la teoria relativistica dell’elettrone ed introdusse la relatività speciale nell’equazione di Schrödinger, nel 1930 con la teoria degli holes (buchi) ipotizzò l’esistenza di una particella come l’elettrone ma di carica positiva (positrone) e quindi dell’antimateria. Il positrone fu scoperto nei raggi cosmici dall’americano Carl D. Anderson nel 1932. Dirac divise con Schrödinger il premio Nobel nel 1933 ed Anderson lo ottenne nel 1936.

Nel 1932 infine, con il matematico John von Neumann, fu completata la formulazione rigorosa della Meccanica Quantistica.

Rimaneva però un certo disagio fra i fisici, ed alcuni di peso non trascurabile fra cui Einstein, per le implicazioni filosofiche che derivavano dall’assoluta aleatorietà dei processi fisici, dal concetto di indeterminazione degli stati, che negava una realtà fisica prima della misura, e dall’ambiguità dello stesso concetto di misura in cui non si definiva quando e perché si verifica il passaggio dal livello subatomico, dove vale la meccanica quantistica, al livello macroscopico dove domina la meccanica classica.

Einstein era un convinto realista e credeva che esistesse una realtà oggettiva indipendente dalle misure e dall’azione degli sperimentatori (la temperatura di un corpo esiste anche se non viene misurata). Celebre è rimasta una frase detta al fisico Abraham Pais, che fu anche suo biografo: ”Veramente lei è convinto che la Luna esista solo quando la si guarda?”. Alla Quinta Conferenza di Fisica dell’Istituto Solvay dell’ottobre 1927, e poi durante la successiva del 1930, Einstein ebbe lunghi dibattiti con Bohr proponendo esperimenti mentali (gedanken experimente) e cercando di dimostrare che grandezze quali velocità e posizione potessero essere misurate indipendentemente con accuratezza arbitraria, Bohr uscì vincitore in questo confronto ma cominciò ad essere chiaro che il problema stava nell’incapacità di definire il confine fra processi microscopici e macroscopici concretizzato infine nell’atto irreversibile del processo di misura. Einstein era inoltre convinto che il concetto di probabilità che la meccanica quantistica assegnava al risultato di una misura non fosse strutturale ma dipendesse dalla nostra ignoranza sui meccanismi profondi del fenomeno. “Dio non gioca a dadi con l’universo” è un’altra famosa frase di Einstein ma Bohr alla fine gli rispose: “non dire a Dio cosa deve fare”. Indeterminazione e probabilità erano per Einstein sinonimi di ignoranza e la meccanica quantistica richiedeva un completamento per renderla deterministica e coerente con la concezione classica. Einstein faceva l’esempio della meccanica statistica nell’ambito della fisica classica in cui l’elaborazione probabilistica era legata alla descrizione incompleta del sistema fisico ed Einstein concludeva che la meccanica quantistica era per lo meno una teoria incompleta.

- L’ENTANGLEMENT ED IL GATTO DI SCHRÖDINGER.

Nei primi anni del decennio 1930 Schrödinger, autore della funzione d’onda, fu il primo a rendersi conto che un sistema quantistico costituito da più particelle può essere legato da una stessa funzione d’onda nello spazio multidimensionale delle configurazioni (non nello spazio tridimensionale), e coniò per esse la parola entangled (in tedesco Verschräukung, in italiano ingarbugliato) e chiamò questo legame “il tratto distintivo della meccanica quantistica” quello che crea una completa frattura con il pensiero classico.

Applichiamo ad esempio il principio di sovrapposizione allo stato di due particelle ciascuna delle quali può trovarsi a sua volta nella sovrapposizione di due stati opposti, come lo spin su e giù di un elettrone o una polarizzazione verticale e orizzontale di due fotoni misurati lungo una coppia di assi perpendicolari, in questo caso le due particelle si dicono “entangled”, cioè legate in senso quanto-meccanico. Per esempio, detti

|a;V> e |b;O> i due stati con polarizzazione verticale ed orizzontale del fotone a, e |b;V> e |b;O> quelli del fotone b, lo stato entangled del sistema dei due fotoni è:

c*|a;V>|b;V> + c*|a;O>|b;O> 5.1)

dove il coefficiente c è l’inverso della radice di 2 che attribuisce una probabilità del 50% al verificarsi della prima o della seconda coppia di stati. Prima della misura il sistema si trova nella sovrapposizione dei due stati, all’atto della misura di a o b il sistema collassa con probabilità c² = 1/2 in uno dei due stati fattorizzati:

|a;V>|b;V> oppure |a;O>|b;O>. Ma questo significa anche che, dovunque vengano portate le due particelle, se si trova che la prima particella è nello stato |a;V> la seconda particella si troverà nello stato |b;V> e, se la prima si trova nello stato |a;O>, la seconda si troverà nello stato |b;O> ma nessuno può sapere a priori lo stato di una delle particelle senza averlo misurato. All’atto della misura sulla prima particella, sia essa a o b, lo stato della seconda si riduce (collassa) istantaneamente nello stato correlato. Schrödinger tuttavia pensava che l’entanglement non potesse persistere oltre una certa distanza fra le particelle.

Si può dimostrare, applicando una trasformazione agli assi di riferimento, che la 5.1) è valida per qualunque coppia di assi perpendicolari comunque orientati m ed n e si può scrivere:

c*|a;m>|b;m> + c*|a;n>|b;n> 5.2)

e quindi in una coppia entangled un fotone ha sempre probabilità ½ di superare il test di polarizzazione lungo una direzione arbitraria e misure eseguite sui due fotoni secondo lo stesso asse danno sempre risultati concordi dovunque essi si trovano. Se poi, una volta misurato il fotone a secondo l’asse m, il secondo operatore volesse misurare il fotone b su un asse z diverso da m, la probabilità di avere un risultato positivo è pari al cos²(m•z) dove m•z è l’angolo fra gli assi m e z e la probabilità di avere risultato negativo è pari a sen²(m•z).

John Wheeler propose di usare come particelle entangled i due fotoni generati dall’annichilimento di un elettrone ed un positrone che dovevano avere due polarizzazioni opposte e la cosa fu ottenuta per la prima volta nel 1949.

Schrödinger, che appoggiò sempre Einstein nelle critiche alla Teoria Quantistica, propose anche un esperimento ideale, rimasto famoso come il “Gatto di Schrödinger”, che metteva in evidenza un paradosso derivato dall’interpretazione di Copenhagen.

“Si suppone che un gatto sia posto all’interno di una scatola chiusa e nella scatola vi sia anche un dispositivo con un nucleo radioattivo che ha la probabilità del 50% di decadere entro un’ora. Quando decade emette una particella che agisce su un attuatore il quale apre un contenitore di gas velenoso che uccide il gatto. Poiché secondo la meccanica quantistica nel corso di quest’ora il nucleo radioattivo si trova in uno stato di sovrapposizione fra decadimento avvenuto e non, se si trasferisce questa sovrapposizione al destino del gatto, anche questo si troverà in una sovrapposizione di gatto vivo e gatto morto.”

Schrödinger con questo voleva dimostrare che la meccanica quantistica era incompleta se non si dava una regola per stabilire quando la funzione d’onda collassava eliminando l’indeterminatezza. Poiché il gatto non poteva essere insieme vivo e morto, anche il nucleo radioattivo non poteva stare in ambedue gli stati e l’atto della misura non poteva avvenire nel momento in cui un osservatore apriva la scatola come voleva l’interpretazione di Copenhagen.

- IL PARADOSSO EPR

Le proprietà dei sistemi entangled mettevano in crisi due concetti irrinunciabili per Einstein, quelli di realtà e di località. Le proprietà delle particelle erano per lui qualcosa di concreto che esistevano indipendentemente dalla misura come elementi della realtà fisica. Credeva inoltre che la località fosse un concetto intuitivo per il quale ciò che succede in un luogo non può influenzare ciò che succede in un altro a meno che un segnale non venga trasmesso dal primo al secondo con velocità non superiore a quella della luce. Nel 1934, quando lavorava nel nuovo Institute for Advanced Study di Princeton negli USA, dopo aver lasciato la Germania, insieme a due fisici più giovani Boris Poldolskij e Nathan Rosen, scrisse il suo ultimo attacco alla teoria dei quanti con un rapporto che divenne noto come il “Paradosso EPR” dalle iniziali dei tre fisici il cui titolo era: “La descrizione quantistica della realtà può essere considerata completa?”.

L’argomentazione partiva dal caso di due particelle entangled, anche lontane fra di loro, ciascuna delle quali ha due stati, rispettivamente a, a’ e b, b’ che possono essere posizione e quantità di moto, descrivibili secondo la meccanica quantistica dalla funzione di stato:

|P> = r*|a>|b> +r’*|a’>|b’> dove r² e r’² sono le due probabilità con r² + r’² = 1,

se si misura la posizione a della prima particella si ha la riduzione istantanea del pacchetto d’onda al prodotto |a>|b> e si conosce quindi anche la quantità b (posizione della seconda particella) con la stessa precisione della prima e senza agire su di essa. Ma se si riesce a prevedere con certezza il valore di una grandezza fisica allora ad essa si può fare corrispondere un elemento di realtà fisica. Poiché il principio di località vieta di pensare che sia stata la misura su a a produrre b, in modo superluminare, con una “spettrale (spooky) azione a distanza” come diceva Einstein, si deve desumere che questo valore era posseduto oggettivamente già in precedenza dal sistema entangled e, poiché il formalismo della teoria non lo giustifica, la teoria è incompleta. Lo stesso vale per la grandezza b’ (quantità di moto della seconda particella) se venisse misurata a’ sulla prima particella.

Einstein aveva colpito un punto delicato e suscitò reazioni diverse fra i sostenitori della teoria quantistica ma una risposta diretta venne tre mesi dopo solo da Bohr che si considerava il padre della teoria. La risposta di Bohr formulata in modo piuttosto oscuro in realtà non affrontò il problema cruciale che era quello della non località e la risposta chiuse il dibattito senza risolvere la controversia. La maggioranza del fisici accettò l’interpretazione ortodossa della teoria in modo acritico pur senza aver risolto questi problemi che sembravano ai più di natura filosofica perché ormai la teoria era stata confermata nelle sue previsioni da tutti i risultati sperimentali. Pochi in realtà compresero a quel tempo la profondità delle osservazioni di Einstein e l’importanza dei problemi irrisolti. La politica e la guerra renderanno più difficili i rapporti della comunità scientifica ed i tentativi di Einstein di trovare una teoria unificante furono infruttuosi, egli morì nel 1955 e Bohr nel 1962 ma il problema era rimasto scottante ed impegnò altre menti che cercarono dapprima di conciliare i contrasti cercando il “completamento” della teoria.

- LE VARIABILI NASCOSTE ED IL TENTATIVO DI BOHM

Il fisico teorico americano David Bohm fu a Berkeley un allievo di Oppenheimer e lavorò alla Princeton University dove studiò la meccanica quantistica ed affrontò il Paradosso EPR. Bohm cercò il completamento della teoria quantistica introducendo dei parametri che potevano essere anche non sperimentalmente accessibili, per cui li chiamò variabili nascoste, ma che potessero dare una spiegazione deterministica a tutti i fenomeni della meccanica quantistica. Nel 1952 Bohm presentò una teoria nella quale le variabili nascoste sono le posizioni di tutte le particelle del sistema fisico sotto esame e dove riprende il concetto dell’onda pilota di De Broglie. La funzione d’onda è quella di Schrödinger, funzione della posizione e del tempo, che si suppone di conoscere perfettamente all’istante zero. Alla funzione d’onda si associa una funzione potenziale quantistico, anche questa funzione della posizione e del tempo, che descrive le forze quantomeccaniche a cui è soggetta la particella e da queste forze dipende la sua evoluzione nel tempo. Il modello e l’introduzione delle forze quantomeccaniche garantisce l’accordo con tutti i risultati della teoria quantistica. Onda e particella sono sempre presenti e l’onda guida la particella nel suo percorso che risulta deterministico. Si spiega così perfettamente l’esperimento della doppia fenditura: la particella, in funzione della sua posizione iniziale, attraversa una sola delle fenditura e la funzione d’onda la guida fino al suo impatto sullo schermo.

La teoria di Bohm lasciò però insoddisfatti sia i seguaci di Einstein che quelli di Bohr. Essa è solo apparentemente un modello classico perché il potenziale quantistico guida la particella esercitando un’azione senza uno scambio di energia. Questa azione è stata interpretata come un’informazione di percorso che riceve la particella, concetto evidentemente non classico, ed inoltre questa informazione ha contributi provenienti da luoghi diversi e quindi non è locale. Riguardo all’entanglement Bohm, come Schrödinger, riteneva che questo non si conservasse all’aumentare della distanza. Nell’esperimento EPR, invece di misurare la posizione e la quantità i moto di due particelle entangled, Bohm pensava di misurare lo spin di due elettroni entangled, ottenuti ad esempio da un’unica sorgente: un pione neutro di spin zero che decade producendo una coppia di elettroni che necessariamente dovranno essere di spin opposti. A qualunque distanza si portassero i due elettroni, se misurando il primo esso risultava con spin su, il secondo avrebbe avuto spin giù per qualunque coppia di assi si facesse la misura. La teoria di Bohm dell’onda pilota spiegava anche questo fenomeno ma era chiaro che il potenziale quantistico aveva un’azione istantanea sullo spin del secondo elettrone come nella teoria di Bohr e così si ritornava alla concezione newtoniana classica di eventi contemporanei per tutti, quindi non relativistica.

Sulle variabili nascoste c’è da aggiungere che il grande matematico John von Neumann, in un suo libro sui fondamenti matematici della meccanica quantistica del 1932, aveva presentato una dimostrazione che affermava l’impossibilità di completarla in modo deterministico e questo aveva scoraggiato i tentativi di altri scienziati. Successivamente però si vide che la dimostrazione era basata su assunzioni discutibili e questo alla fine sarà messo in risalto da John Bell.

- LA DISUGUAGLIANZA DI Bell

Il fisico John Steward Bell, nato a Belfast in Irlanda nel 1928, ebbe una brillante carriera dopo aver preso un dottorato in fisica a Birmingham nel 1956 ed essersi specializzato in fisica nucleare e meccanica quantistica. Nel 1963 approfondì la problematica del paradosso EPR e della proposta di Bohm e comprese che questa è fondamentalmente non locale e che i concetti di località e realismo insiti in EPR erano incompatibili con la teoria dei quanti: se i primi erano validi qualcosa doveva essere sbagliato nella descrizione del mondo microscopico. Bell affrontò il problema usando il calcolo delle correlazioni nelle misure di sistemi che rispettano il postulato di località. Anche se il modo di procedere di Bell è stato diverso, si può seguire il seguente ragionamento. Consideriamo due osservatori A e B, detti Alice e Bob, che eseguono misure di polarizzazione piana di fotoni entangled secondo coppie di assi perpendicolari X e Y, in modo concorde o no, ed assegnano +1 nel caso che il test riesca e -1 se fallisce. Secondo la teoria quantistica, ripetendo la prova un gran numero di volte, i due valori +1 e -1 si ottengono con la stessa frequenza ma ciò che risulta strano è che, quando i due osservatori eseguono misure sullo stesso asse comunque scelto, ottengono sempre risultati concordi, ambedue +1 o ambedue -1, come se fra i due fotoni ci fosse una telepatia, fatto che non viene spiegato dalla teoria ma è una conseguenza del formalismo delle particelle entangled. Invece l’esigenza EPR di località e realtà proprio per questo fa giudicare la teoria incompleta. La teoria quantistica implica cioè una correlazione statistica fra le misure più forte rispetto ad un sistema locale perché le coppie di fotoni entangled costituiscono un sistema coerente e mettono in evidenza proprietà comuni quando viene eseguita una misura. Su una serie di misure di polarizzazione come sopra indicato, il numero delle risposte concordi sarebbe stato, secondo la teoria quantistica, superiore a quello delle risposte discordi a causa di questo effetto di telepatia.

La diseguaglianza definita da Bell nel 1964 per i sistemi locali combina la differenza delle probabilità fra esiti concordi e discordi per quattro orientamenti arbitrari delle polarizzazioni e prevede un risultato compreso fra -2 e +2. In questo modo Bell, che condivideva all’inizio le idee di Einstein, ha trasformato un contrasto difficile da conciliare perché basato sui diversi presupposti filosofici, del positivismo dei sostenitori di Bohr e del realismo di EPR, in un’espressione matematica suscettibile di misura e quindi capace di sciogliere il dilemma.

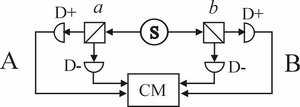

Facendo riferimento allo schema della Figura 8.1, due fotoni entangled vengono inviati dalla sorgente S rispettivamente verso A e verso B e ciascuno viene smistato in modo casuale su due polarizzatori i cui piani sono scelti dallo sperimentatore. Indichiamo con a e a’ i piani di polarizzazione scelti sul lato A e con b e b’ quelli scelti sul lato B. Le uscite dei rivelatori D vengono inviate ad un Coincidence Monitor (CM) che ne fa il prodotto logico e le accumula.

Figura 8.1

Bell definì la funzione di Correlazione Quantistica E(a,b) come la somma delle probabilità di avere risultati concordi meno quella di avere risultati discordi per le polarizzazioni a e b, cioè:

E(a,b) = p(a,b;+1,+1) + p(a,b;-1,-1) – p(a,b;+1,-1) – p(a,b;-1,+1) 8.1)

se si ammette il principio di località deve risultare che la probabilità congiunta è pari al prodotto delle due probabilità separate, cioè:

p(a,b;+1,+1) = p(a;+1)p(b;+1) 8.2)

ed in modo analogo si possono scrivere le altre probabilità della 8.1). Sostituendo questi valori nella 8.1) si ha:

E(a,b) = p(a;+1)p(b;+1) + p(a;-1)p(b;-1) – p(a;+1)p(b;-1) -p(a;-1)p(b;+1) =

[p(a;+1) – p(a;-1)]p(b;+1) – [(p(a;+1) – p(a;-1)]p(b;-1) = [p(a;+1) – p(a;-1)] [p(b;+1) – p(b;-1)]

se si considera ora che:

p(a;+1) + p(a;-1) =1

ricavando e sostituendo p(a;+1) si ha:

E(a,b) = [1 – 2p(a;-1)] [1 – 2p(b;-1)]

Poiché le probabilità sono comprese fra 0 ed 1, ciascuno dei due fattori è compreso fra 1 e -1 e così anche il loro prodotto.

Calcolando ora la funzione E per le altre tre combinazioni possibili di polarizzazione: a, a’, b, b’, e a’, b’, si ottengono analogamente le:

E(a,b’), E(a’,b), E(a’,b’)

anche queste sempre comprese fra 1 e -1.

Bell combinò le 4 funzioni secondo l’espressione:

-2 >= E(a,b) – E(a,b’) + E(a’,b) + E(a’,b’) <= +2 8.3)

che evidentemente deve essere sempre compresa fra -2 e +2.

Questa è la famosa disuguaglianza di Bell che sembra un trucco algebrico perché i quattro termini sono tutti compresi fra 1 e -1 ma il risultato deriva direttamente dalla condizione di località imposta con la 8.2).

Se si calcolano invece le probabilità della 8.1) seguendo il formalismo quantistico, ricordando la discussione della 5.1), si trova che:

p(a,b;+1,+1) = p(a,b;-1,-1) = ½cos²(a•b)

p(a,b;+1,-1) = p(a,b;-1,+1) = ½sen²(a•b)

essendo a•b l’angolo fra gli assi secondo cui si misura la polarizzazione dei fotoni a e b; quindi:

E(a,b) = cos²(a•b) – sen²(a•b) = cos2(a•b)

e analogamente:

E(a,b’) = cos2(a•b’), E(a’,b) = cos2(a’•b), E(a’,b’) = cos2(a’•b’)

Se si scelgono come valori per i 4 assi di polarizzazione:

a = 0°, b = 22,5°, a’ = 45°, b’ =67,5°

che sono quelli per cui si ha teoricamente la violazione massima della 8.3), calcolando la funzione di Bell si ottiene:

E(a,b) – E(a,b’) + E(a’,b) + E(a’,b’) = cos(45) – cos(135) + cos(-45) + cos(45) = 4c = 2,828 8.4)

che è notevolmente maggiore di 2.

Bell ha così dimostrato che l’approccio locale porta a risultati diversi da quello non locale del formalismo quantistico ma ha anche indicato una strada per risolvere sperimentalmente la contesa filosofica. Lo schema di Figura 8.1 rappresenta un modo diretto di misurare le correlazioni quantistiche E combinando tutti i possibili assi secondo cui misurare le polarizzazioni delle coppie di fotoni entangled. Il Coincidence Monitor CM, accumulando i prodotti logici delle coppie di risultati e rapportandolo al numero totale di prove, calcola

le funzioni di correlazione E e sarà quindi in grado di verificare se esiste una violazione della disuguaglianza di Bell.

Nel 1969 la diseguaglianza di Bell fu perfezionata da un gruppo di quattro ricercatori, Clauser, Horne, Shimony ed Holt, come Diseguaglianza CHSH e ad essa si è fatto riferimento nelle successive prove sperimentali.

- LE PROVE SPERIMENTALI E LE CONSEGUENZE

In un decennio, fra il 1972 ed il 1982, i laboratori raccolsero la sfida lanciata da Bell ed affrontarono le numerose difficoltà pratiche connesse con l’esperimento. Il primo problema stava nella realizzazione affidabile di coppie di fotoni entangled e questa fu ottenuta sfruttando le proprietà degli elettroni di atomi di calcio che, una volta eccitati, ritornavano al livello fondamentale emettendo coppie di fotoni correlati. Le prime misure furono subito favorevoli alla teoria quantistica e violavano la diseguaglianza di Bell ma la tecnica di misura non era raffinata e lasciava molto a desiderare. Il risultato considerato definitivo fu quello del fisico Alain Aspect dell’Università di Parigi nel 1982; questi era rimasto colpito dagli scritti di Bell e si convinse che la disputa fra Bohr ed Einstein stava tutta nel fatto che non potevano essere ambedue vere le affermazioni che “era completa la descrizione della funzione d’onda” o che “due particelle spazialmente separate erano fra di loro indipendenti”. Nel progettare il suo esperimento Aspect volle che le due postazioni separate A e B (Alice e Bob) fossero realmente indipendenti e non fosse possibile uno scambio di informazioni fra di esse e per questo adottò il criterio della scelta ritardata. La distanza fra le due postazioni e la velocità di commutazione nella scelta fra i due assi garantivano che i due fotoni erano già partiti e non c’era più tempo per trasferire una eventuale informazione da possibili variabili nascoste fra le due postazioni. La distanza fra A e B era infatti di 13 m (equivalente ad un ritardo di 43 nanosecondi alla velocità della luce) mentre la commutazione avveniva in meno di 15 nanosecondi ed inoltre la scelta veniva fatta in modo casuale. I risultati confermarono le aspettative della teoria quantistica come calcolate dalla 8.4).

Gli esperimenti di Aspect hanno quindi dimostrato che l’ipotesi di località posta alla base del teorema di Bell non è valida in natura nel mondo microscopico e con questo cadeva tutta una vecchia visione del mondo e cadeva anche la possibilità di formulare una teoria realistica locale capace di riprodurre tutti i risultati della teoria quantistica sull’esempio di Bohm. Il paradosso EPR è dovuto al fatto che l’intuizione della fisica classica non è applicabile alla realtà fisica del mondo microscopico e si deve concludere che l’idea dell’esistenza di una realtà fisica alla base delle proprietà osservate nei sistemi quantistici, su cui si fondava la filosofia EPR, è indimostrabile. Anche se esistono comportamenti strani e contro-intuitivi delle particelle elementari esse contraddicono solo le nostre attese e non i fatti sperimentali in sé e quindi non rappresentavano dei paradossi nella definizione del termine. Anche l’entanglement, contrariamente a quanto molti pensavano all’inizio, persisteva a distanza. L’unica realtà fisica è fornita dalle misure all’atto delle quali la molteplicità degli stati quantici prevedibili dal formalismo della teoria si riduce (collassa) in uno solo, in modo fondamentalmente indeterministico.

La connessione causale istantanea che si verifica all’atto di una misura fra particelle entangled, conseguenza della non località fece sorgere un altro problema. Essa sembrava rappresentare una violazione dei principi relativistici e subito qualcuno si convinse che si potessero trasferire informazioni a velocità superluminare (fra questi il filosofo Karl Raimund Popper) ma l’impossibilità venne dimostrata in modo rigoroso. In termini intuitivi, anche se i risultati delle prove eseguiti su assi uguali sulle due particelle ai due estremi di Alice e Bob risultano sempre concordi, la loro sequenza è completamente casuale; Alice non può controllare a priori il risultato e quindi non può trasmettere nessuna informazione.

- DAL MONDO MICROSCOPICO A QUELLO MACROSCOPICO

Al tempo di Bell e di Aspect la teoria quantistica si era ormai affermata fra i fisici perché i risultati sperimentali avevano sempre confermato le sue previsioni e le discussioni filosofiche non avevano intaccato la fiducia in essa. Tuttavia ciò che rimaneva ancora ambiguo, indeterminato e realmente inspiegabile nell’interpretazione di Copenhagen era l’istante della misura ed il modo con cui lo stato quantistico fino a quel momento probabilistico ed indeterminato secondo la funzione d’onda si riduce ad un solo valore determinato che così rientra nei canoni della fisica classica e come mai i comportamenti quantistici non si osservano nel mondo reale anche se tutto è costituito da particelle che rispondono alle regole della fisica

quantistica. Era in sostanza il problema aperto dal “Gatto di Schrödinger. L’interpretazione di Copenhagen afferma che la funzione d’onda si riferisce ad un “osservabile” cioè al sistema costituito da particelle quantistiche e dal dispositivo di misura e lascia ambiguo il fatto se il sistema di misura comprenda anche un osservatore cosciente cosa che aveva fatto chiedere a Einstein se la Luna esisteva quando nessuno la osservava. Un sistema di misura è un sistema macroscopico fatto però di componenti microscopici ed è la sua interazione con le particelle quantistiche dell’esperimento che produce il salto quantico nella funzione d’onda ma si tratta di stabilire come, quando e dove ciò si verifica.

Se si riprende in considerazione l’esperimento di Young delle due fenditure è chiaro che l’atto della misura avviene quando il fotone colpisce il secondo schermo, che può essere ad esempio una lastra fotografica, ed interagisce con la sua struttura macroscopica ma si è detto anche che l’esperimento si può ripetere con particelle di dimensioni non più microscopiche come i fullereni; in questo caso però può diventare critico e, se non avviene nel vuoto spinto, si verifica una perdita di coerenza nell’interazione con le molecole dell’aria e le frange di interferenza diventano sfumate fino a sparire. Sembra che non si debbano superare certe dimensioni affinché si mantengano le proprietà di coerenza quantistica ma questo limite non è netto e definibile. Ci sono anzi esempi di comportamenti quantistici con sovrapposizioni di stati in sistemi decisamente macroscopici come quello formato da un anello superconduttore interrotto da una giunzione Josephson che permette il passaggio per effetto tunnel degli elettroni. Una volta eccitato l’anello viene percorso da due correnti, destrorsa e sinistrorsa, che si alternano in una sovrapposizione quantistica e si tratta di correnti dell’ordine di 50 nanoAmpere. Quindi se si scende verso il mondo microscopico compaiono prepotentemente i comportamenti quantistici ma se si risale verso una complessità macroscopica non si trova un transizione netta ai comportamenti della fisica classica. Si deve pensare che il mondo macroscopico non è mai esattamente classico, perché è sempre il risultato dell’interferenza caotica di tutte le funzioni d’onda delle particelle elementari che lo costituiscono, ma ai fini pratici lo si può considerare tale.

Nel decennio del 1980 si comprese il fenomeno della decoerenza quantistica prodotta dall’interazione delle particelle quantistiche coerenti con una molteplicità di elementi microscopici indipendenti dell’ambiente naturale. La decoerenza si può calcolare in un incerto istante di transizione fra micromondo quantistico ed il mondo dove è applicabile l’intuizione classica e provoca la conversione delle probabilità quantistiche nelle normali probabilità classiche. Con la decoerenza il sistema quantistico perde in un processo irreversibile la coerenza di fase fra i suoi componenti e tutte le proprietà associate come sovrapposizione di stati ed entanglement. Non è stata invece mai accettata come scientifica l’affermazione che nella misura e nel processo di decoerenza sia necessario l’intervento di un operatore cosciente.

Applicata all’universo la meccanica quantistica abolisce il determinismo assoluto, già in pratica superato con la teoria del caos nella fisica del mondo classico, ma questo perché la probabilità è insita nella decoerenza degli stati quantici; l’origine stessa dell’universo potrebbe essere un fenomeno quantistico e le storie possibili dell’evoluzione sono infinite ma ciascuna obbedisce alle relazioni di causa ed effetto nel comportamento macroscopico dei grandi sistemi.

Tuttavia la non località e la mancanza di una realtà oggettiva pongono la meccanica quantistica fuori dalla nostra comprensione intuitiva e noi non possiamo fare a meno di avvertire come contradditori i comportamenti del mondo microscopico alla luce della nostra esperienza del mondo macroscopico. Possiamo concludere che rimane valido quanto detto dal grande fisico Richard Feynman nel 1964 nel corso delle sue conferenze all’università Cornell: “penso che si possa dire con sicurezza che nessuno capisce la meccanica quantistica”, “possiamo dire come funziona ma non spiegare come funziona”. Fra le tante domande che si pone ancora la scienza c’è anche quella se vi siano spiegazioni più profonde alla base di queste stranezze (Science, 1 July 2005, Vol 309, pag. 75, “What don’t We Know?”).

- APPLICAZIONI DELLA COERENZA QUANTISTICA

Anche se è impossibile a livello quantistico trasmettere informazioni a velocità infinita le proprietà di coerenza dei sistemi quantistici hanno dato l’avvio a delle applicazioni inconcepibili nel mondo macroscopico dominato dalla fisica classica. La prima applicazione di carattere pratico è stata quella della crittografia inviolabile perché basata su un codice prodotto con procedimento quantistico. La seconda, ancora rimasta nei laboratori, è quella del teletrasporto di uno stato quantistico fra due siti distanti sfruttando l’entaglement, una realizzazione che sembra anticipare operazioni che la fantascienza ha reso popolari come il trasferimento di esseri viventi a distanza. La terza applicazione è il progetto di un calcolatore quantistico

che dovrebbe consentire un salto qualitativo nella manipolazione dei dati sfruttando la sovrapposizione degli stati quantistici.

- CRITTOGRAFIA QUANTISTICA

Come è noto la crittografia è basata su codici casuali noti al mittente ed al destinatario, indicati anche qui come Alice e Bob, con cui eseguire permutazioni nelle lettere dell’alfabeto per ottenere il messaggio cifrato e poi decrittarlo in arrivo con lo stesso codice. Un codice sicuro però deve avere una lunghezza pari a quella del messaggio da inviare, deve avere una sequenza realmente casuale e deve essere cambiato ad ogni messaggio perché, se la stessa sequenza di codice viene utilizzata a lungo, è sempre possibile ricostruirla. Inoltre non esistono canali sicuri per scambiarsi i codici senza pericolo di intercettazione perché se ne esistesse uno lo si potrebbe usare per trasmettere in chiaro il messaggio stesso. Il problema è quindi trovare una procedura di creazione di un codice comune ad Alice e Bob indifferente ad ogni intercettazione. Il metodo trovato sfrutta il fenomeno di entanglement dei fotoni. Una sorgente invia coppie di fotoni entangled ad Alice e Bob che eseguono su di essi misure di polarizzazione su due direzioni con una sequenza che ognuno sceglierà a caso ma che renderanno pubblica; quindi ambedue sapranno in quali misure avranno usato polarizzatori discordi. Alice e Bob, che hanno concordato di segnare con 0 i risultati negativi e con 1 quelli positivi, cancellano dalla sequenza i risultati con polarizzatori discordi e lasciano solo le misure eseguite con polarizzatori concordi che sono identiche ma con una sequenza casuale di 1 e 0 che nessuno conosce. Alice e Bob hanno così ottenuto un codice con le caratteristiche richieste. Si deve aggiungere che, in grazia alle proprietà dei fotoni entangled, se una spia cercasse di misurare la polarizzazione del fotone in una delle due direzioni e superasse la prova, ambedue i fotoni della coppia risulterebbero polarizzati secondo questa direzione. Naturalmente nel caso che il tentativo di intrusione avvenisse quando Alice e Bob misurano su assi fra loro diversi non ci sarebbero conseguenze perché questo risultato verrà scartato, quando Alice e Bob misurano con assi concordi i casi che interessano invece sono solo due: 1) Alice e Bob scelgono la stessa direzione della spia ed allora i loro risultati sarebbero coincidenti e quindi validi, 2) Alice Bob scelgono l’altra direzione e si potranno verificare 4 casi equiprobabili, due concordi e due discordi. Combinando i casi 1) e 2) la probabilità di avere risultati concordi e quindi validi è di (1+1/2)/2 =3/4 e solo 1/4 è la probabilità che il codice sia stato corrotto. Alice e Bob possono allora adottare una strategia per scoprire la presenza di una spia. Possono scambiarsi i risultati di un certo numero n di dati del codice, ad esempio tutti quelli di ordine pari, che verrebbero però cancellati dal codice perché resi pubblici, e possono così verificare se c’è corruzione (valori discordi); la prova è altamente affidabile perché, in presenza di una spia la probabilità che tutti i valori scambiati siano concordi è di (3/4)^n, valore che può essere molto piccolo per n grande. Questa strategia è sempre valida anche per scoprire la presenza di disturbi. La crittografia quantistica è stata già applicata trasmettendo i fotoni su fibre ottiche.

- IL TELETRASPORTO QUANTISTICO

Nel mondo della fisica classica la riproduzione di un oggetto da un luogo ad un altro richiede la completa caratterizzazione delle sue proprietà mediante misure, il trasferimento delle informazioni al luogo di destinazione e la ricostruzione dell’oggetto su queste basi. Ma secondo la meccanica quantistica questo processo realizza solo un “facsimile” e non una copia fedele all’originale perché le proprietà quantistiche delle particelle costituenti non si possono conoscere per il principio di indeterminazione di Heisenberg.

Il teletrasporto quantistico è stato ipotizzato nel 1993 da Charles Bennett in un articolo sulla rivista Physical Review Letters avanzando la possibilità di trasferire lo stato quantistico di una particella su un’altra particella sotto condizione di non cercare di ottenere informazioni sullo stato della particella da trasferire perché qualsiasi misura su di essa farebbe collassare la sua funzione d’onda. Una prima condizione quindi è che la teletrasmissione avvenga a scatola chiusa. Inoltre non è possibile clonare uno stato quantistico e la conseguenza è che nel processo si distrugge la particella sul lato mittente e la si ricostruisce sul lato destinatario. Un’altra condizione e che la ricostruzione richiede un’istruzione che il mittente deve inviare al destinatario su un canale classico per operare la ricostruzione. Il procedimento non infrange quindi i principi della relatività.

Il teletrasporto sfrutta due particelle entangled, A e B, che collegano i due siti detti di Alice e Bob, rispettivamente mittente e destinatario. La particella quantistica da trasferire, C, è fornita ad Alice che come si è detto non può misurarla, onde evitare l’alterazione dell’informazione contenuta, ma la combina con la particella A e misura lo stato congiunto (entangled). Il risultato della misura sarà uno di 4 possibili stati

ciascuno relazionato allo stato di C. Istantaneamente la misura di Alice fa collassare sullo stesso stato quello della particella B sul lato di Bob. Alice trasmette il risultato della sua misura codificandolo con 2 bit (i 4 valori possibili) a Bob ed utilizzando un canale di trasmissione classico a velocità relativistica. Ricevuto il messaggio, Bob può applicare alla particella B la trasformazione appropriata (che può essere anche quella unitaria che lascia invariata la particella) per ottenere la replica teletrasportata dello stato C. Sul lato di Alice la misura ha però reso inutilizzabili gli stati di A e C originari.

- IL CALCOLATORE QUANTISTICO

Nel decennio 1980 Richard Philips Feynman del California Institute of Technology (Caltech) applicò i processi quantistici alla scienza delle informazioni e considerò come unità di informazione la sovrapposizione di due stati quantici |0> + |1> che fu detta qubit la cui funzione di stato è:

|P> = 2^-½*[|0> + |1>] 11.1)

Si può pensare di realizzare un tale bit quantistico con uno ione immagazzinato in uno stato di bassa energia definito come |0> che si può portare ad un livello di energia eccitato |1> con un raggio laser di una certa frequenza e di una certa durata. Ma se si illumina lo stato |0> per un tempo metà di quello necessario a portarlo allo stato |1>, lo stato finale sarà la sovrapposizione dei due stati della 11.1).

Se si considerano due qubit entangled la loro funzione di stato complessiva è il prodotto delle due, cioè:

|P> = ½*[|00> + |01> + |10> + |11>] 11.2)

con un contenuto di informazione di 4 coppie di stati ciascuna con probabilità ¼. Nel caso di n qubit entangled si trova infine che il contenuto di informazione è costituito da tutti i 2^n numeri di n bit in sovrapposizione quantistica ciascuno con probabilità (1/2)^n. Come si vede l’informazione cresce in modo esponenziale con n e così anche la potenza di calcolo di un computer quantistico che potrebbe eseguire in parallelo un gran numero di operazioni sfruttando il principio di sovrapposizione quantistico. Questo da al computer quantistico una capacità sconosciuta ai computer classici che non sono in grado di risolvere problemi la cui complessità computazionale è di tipo polinomiale od esponenziale in relazione ad un parametro N perché i tempi di calcolo divergono rapidamente con N e la durata del calcolo diventa impraticabile per qualunque calcolatore. Problemi di questo genere sono ad esempio la scomposizione in fattori di grandi numeri, importante in crittografia, o il famoso problema del commesso viaggiatore che vuole trovare il minimo percorso da seguire per visitare i suoi N clienti. Questi problemi sarebbero invece accessibili ad un calcolatore quantistico. Ad esempio gli attuali supercomputer richiederebbero miliardi di anni per decomporre in fattori primi un numero di alcune centinaia di cifre mentre un computer quantistico impiegherebbe pochi secondi.

I problemi da risolvere per la realizzazione pratica di un calcolatore quantistico sono però ancora enormi. Oltre alla realizzazione di un numero sufficiente di qubit entangled ed al problema della lettura dei singoli qubit senza disturbare gli altri restanti, l’elemento limitativo è ancora il fenomeno della decoerenza che riduce il tempo di operatività del calcolatore nonostante lo sviluppo di metodi di fault-tolerance con l’uso di codici di correzione degli errori quantistici.